Доводилось ли вам смотреть на мир «глазами» автопилотируемой машины? Я не упустил такого случая, когда мне предложили в VR-шлеме понаблюдать в режиме real time за ездой беспилотного желтого фургона Deutsche Post DHL. Отрисованная парой вращающихся лидаров (лазерных дальномеров) объемная «матрица» из тысяч цветных точек и линий оказалась до того подробной, что я различил в трехмерном «скане» окружающей действительности контуры испытательной площадки, ограждения и обочины с покачивающимися деревьями, шатер с оборудованием и толпу зрителей. Можно было переключить ракурсы, осмотреть площадку сверху или сзади, переместиться на виртуальное место шофера и «взяться» за такой же виртуальный руль.

Они все видят

Хотя демонстрация машинного зрения произвела сильное впечатление, это лишь малая часть возможностей электроники. Говорят, для курьерской автономной машины, которая должна неспешно объезжать по заданному маршруту адресатов, пока сотрудник почтовой службы, следуя рядом, вынимает из ящиков корреспонденцию и вручает посылки, большего и не требуется.

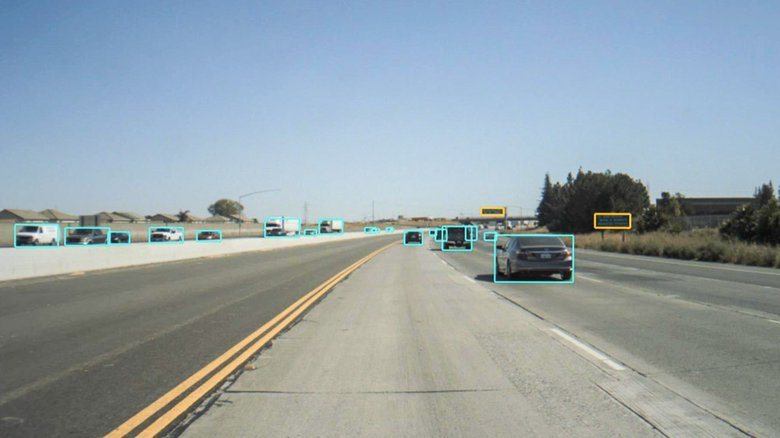

С пассажирскими беспилотниками высшего пятого уровня автономности куда сложнее. На них будут стоять с десяток скрытых камер, радаров и лидаров. Они смогут видеть мир гораздо лучше, чем люди, и ездить по любым дорогам, не нарушая правил и исключая ДТП по вине человеческого фактора. А продвинутые автопилоты станут наматывать круги по трекам быстрее самых одаренных автогонщиков.

Эксперты считают, индустрии понадобится несколько лет, чтобы обеспечить разработчиков автоматизированного управления достаточно совершенными автомобильными «органами чувств». Дальше — переход на конвейер, массовое производство, удешевление. К слову, при помощи HD-камер и высокоточных сенсоров резко ускорится и процесс создания детализированных карт. Фокус в том, что сами беспилотники будут оцифровывать те местности, по которым им придется колесить. Причем к тому времени уже вырастет инфраструктура — дата-центры, облачные хранилища, системы высокоскоростной мобильной связи.

Силиконовая голова кругом

Чтобы в окружающем мире распознавать те же объекты, что видим мы, беспилотникам придется усваивать гигантские потоки данных. До недавних пор это было проблемой. Алгоритмические методы, в которых необходимые параметры рассчитываются процессором по заранее написанным (и непростым) программам, для задач распознавания не подходят. Ведь «на лету» надо обрабатывать тысячи объектов, делая это без ошибок и задержек, — слишком сложный и чудовищно энергоемкий процесс для обычного компьютера.

Однако, выход нашли, причем двадцать лет назад, когда появились первые геймерские видеокарты и приставки. Сейчас вы читаете этот текст на дисплее ноутбука или смартфона, но визуальное представление генерирует не основной процессор CPU, а так называемый GPU — ускоритель для графики. Работает он по совсем иному принципу: оперирует не громоздкими кодами алгоритмов, а простейшими арифметическими действиями, распределенными по огромному числу параллельных процессов. Похожий метод применяется и в больших суперкомпьютерах, превосходящих обычные в вычислительной мощности в миллионы раз. Но только GPU решает задачку попроще — получив указание создать на экране столько-то объектов, он вмиг обсчитывает миллионы элементов будущего изображения и выдает «раскадровку» пикселей для отображения матрицей дисплея.

А теперь представьте, что GPU заставили делать как бы обратный процесс: мы ему транслируем видеоизображения с камер машинного зрения автопилота, а он берется молниеносно распознавать в нем объекты...

Входим в матрицу

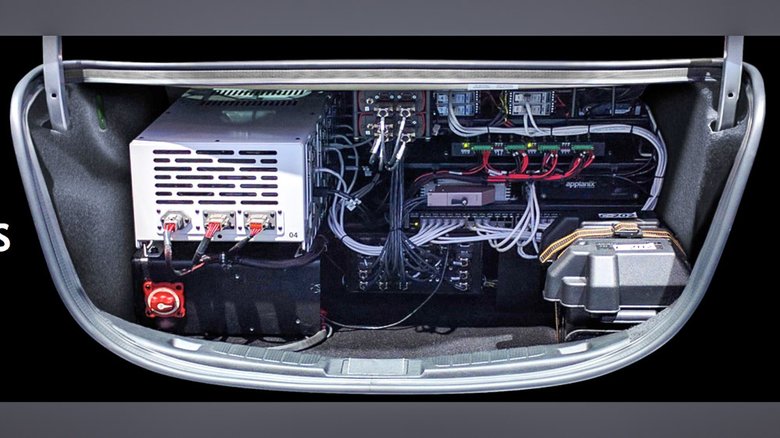

Именно по такому пути пошли производители графических карт. Больше других преуспела калифорнийская Nvidia, в начале 2015-го представившая платформу для автономного вождения Drive PX. Год спустя дебютировало еще более мощное второе поколение, которое взяла на вооружение компания Tesla, успешно воплотившая на ней автопилотирование с водительской подстраховкой.

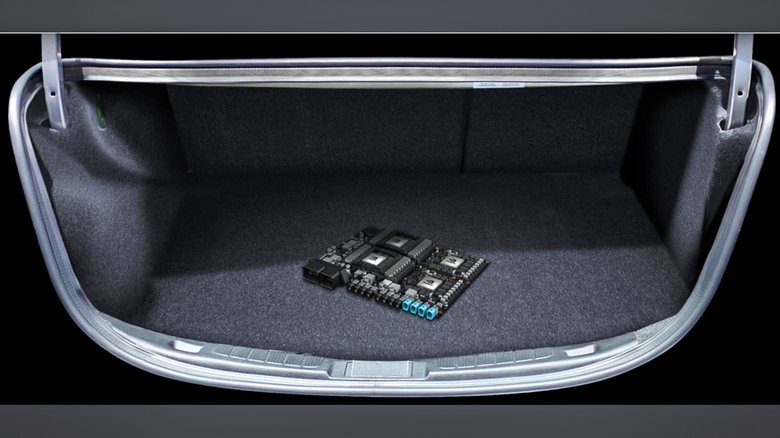

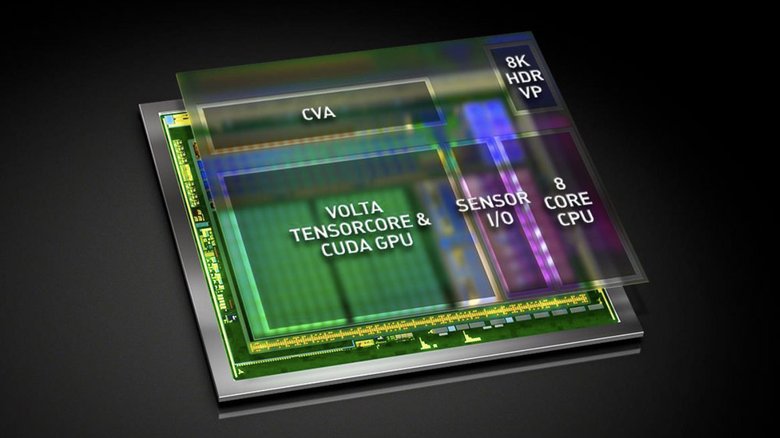

Самая мощная инновация Nvidia — выпуск первого в мире специализированного автомобильного процессора Xavier, объединившего 8 ядер CPU, 512 GPU и новую архитектуру Volta для скоростного выполнения параллельных тензорных вычислений (это значит, процессор оперирует целыми матрицами данных, далее мы объясним, для чего это надо). А осенью этого года компания представила сделанную на базе двух Xavier и двух дискретных GPU-ускорителей платформу Drive PX Pegasus.

Она снимает «процессорный» фактор с повестки дня. С ней инженеры уже сегодня могут браться за создание беспилотников пятого уровня. Система третьего поколения в сотни раз производительнее предшественниц — она выполняет до 320 триллионов операций в секунду! Впрочем, сравнивать ее вычислительную мощь напрямую с большими суперкомпьютерами некорректно. Производительность последних исчисляют в операциях типа FLOP (вычисление с плавающей запятой), а новые тензорные процессоры «специализируются» на операциях типа DL (Deep Learning, глубокое обучение). И вот здесь мы подошли к самому главному.

Что еще за обучение?

Хотя упомянутые чипы и наделены миллиардами транзисторов, изначально они — не более чем «пустышки» на кремниевой подложке. Осмыслять происходящее в реальном времени системы смогут только с помощью искусственного интеллекта, на который и ложится вся нагрузка. Во-первых, это отслеживание постоянно меняющихся сигналов с внешних радаров и лидаров. Во-вторых, анализ видеопотоков от высокочувствительных камер для распознавания стационарных и движущихся объектов, свободных зон и едва видимых препятствий (ограничители, полосы разметки, светофоры, указатели, барьеры). В-третьих, работа по проверке данных и их сопоставлению с координатами для точной ориентации в пространстве. В-четвертых — выработка управляющих команд для автомобиля. В идеале мозг должен предугадывать развитие событий по характеру поведения объектов, и, наконец, уметь коммуницировать с человеком — распознавать речевые команды и выстраивать диалог, следить за эмоциональным и физическим состоянием, правильно трактовать мимику, движения глаз и жесты, изучать привычки...

Эту способность к разумному поведению система обретает в ходе глубокого обучения. Сначала через ее нейросети прогоняют огромное число возможных объектов и ситуаций, но с известными (или рассчитанными) «ответами» на выходе, чтобы в системе сформировались необходимые матрицы коэффициентов. И лишь после Deep Learning тензорный процессор сможет делать обратное: в гуще входящих сигналов мгновенно различать уже знакомые ему визуальные объекты и звуковые образы.

Автошкола роботов

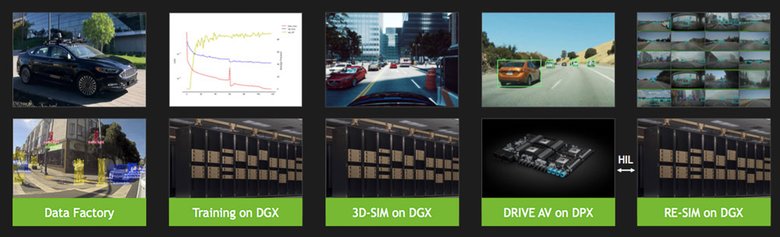

Для натаскивания интеллекта беспилотников потребуются экзабайты исходной информации, собираемые в реальном мире. Также понадобятся разные методики глубокого обучения, самообучения и даже элементы дрессуры (когда искусственный интеллект за свои действия получает «кнут» или «пряник»). Будут нужны детальные 3D-симуляции транспортных условий для экзаменации «учеников». А заодно — и виртуализация самих роботов для ускоренного обучения и диагностики возможных отклонений. И все это, наконец, немыслимо без вычислительных ресурсов самых высокопроизводительных дата-центров.

Но эпоха искусственного интеллекта уже наступила. Показательный факт: восемь объединенных «суперперсоналок» NVIDIA DGX при тренинге автопилотов уже способны «проезжать» по всем дорогам США за пару суток. Это значит, в ближайшем будущем дата-центры начнут массово обучать беспилотники, скармливая им миллионы километров в час.

Откуда взяться таким объемам данных? Ответ: от все тех же беспилотников. Тотальным сканированием автомагистралей, перекрестков и улиц занимаются едва ли не все взявшиеся за «автономные» проекты компании: Google, Baidu, Uber, Yandex, Lyft, Argo.ai/Ford, Cruize/GM, nuTonomy, Zoox... Все выпущенные автомобили Tesla, в том числе и с программно-деактивированным Drive PX, тоже накапливают дорожные данные благодаря «фоновому» режиму автопилота. А завтра эту армию разведчиков, по всей видимости, пополнят и новые модели от ведущих автопроизводителей — свое сотрудничество с Nvidia подтвердили Audi, Volvo, Mercedes-Benz, Toyota и еще несколько компаний.

Поэтому не удивляйтесь, если через пару лет вы себе приобретете с виду самый обычный автомобиль, а через какое-то время он внезапно заговорит человеческим голосом, поинтересуется адресочком и вежливо попросит вас пересесть с водительского места на задний ряд.

БОНУС

Какие автомобили представили на GTC?

Руслан Тарасов

Фото автора и Nvidia